John Smith

You have 4 new messages

You have 4 new messages

Ottimizzare l’infrastruttura in modo da poter offrire ai potenziali clienti un’esperienza gratificante è quindi il primo step per il successo. Il load balancer è uno strumento fondamentale in questa architettura ideale: rende la rete più veloce, scalabile e sicura, con benefici significativi a livello di costi e di qualità UX.

[divilifeshortcode id=’9530′]

Oltre che una questione tecnica, la velocità di caricamento per un sito è un aspetto sempre più importante. Questo è vero sia per Google – che lo considera un fattore determinante per il ranking – sia per gli utenti, che mentre la rotellina continua a girare possono decidere di uscire dal tuo sito e passare a quello di un tuo competitor.

Per abbattere i tempi di caricamento e fornire una navigazione veloce anche in contesti dove c’è una grande oscillazione di traffico e quindi di utilizzo delle risorse (si pensi al sito di una big company o a un e-commerce con migliaia di prodotti), diventa quindi fondamentale giocare tutte le carte che la tecnologia oggi offre. Il load balancing è una fra queste e fra i processi che la tua infrastruttura dovrebbe gestire non può mancare. Vediamo perché.

Quello del load balancing – ovvero del bilanciamento dei carichi sulle risorse disponibili – è un sistema di distribuzione dei contenuti web ideato per gestire in maniera efficiente i carichi. Ogni sito web è soggetto nei vari periodi della giornata o dell’anno a variazioni dei flussi di traffico e questo assume particolare importanza quando si tratta di oscillazioni notevoli.

Per siti di importanza strategica per il business diventa quindi fondamentale monitorare costantemente tutte le metriche relative all’utilizzo delle risorse e gestire i picchi in modo da poter garantire questi requisiti:

Il load balancing può essere effettuato a livello fisico, ovvero installando dei server deputati a questa funzione, oppure virtuale, attraverso la gestione di un software. Nel primo caso si ha a che fare un’infrastruttura statica dai costi elevati, mentre nel secondo si ha un’infrastruttura in grado di adattarsi in tempo reale al traffico effettivo.

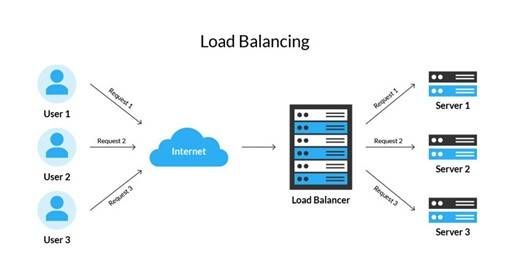

I load balancer possono essere configurati con varie modalità di routing delle richieste; in ogni caso la struttura funge da interfaccia unica tra client e i diversi server verso i quali distribuisce, solitamente dislocati in aree geografiche diverse. Vediamo lo schema di funzionamento generico (ogni sistema può avere caratteristiche diverse, a livello di regole di smistamento, gestione degli indirizzi IP, ecc.):

Le priorità in base alle quali il software assegna le richieste che gli arrivano ai vari cluster dipendono dalla logica dell’algoritmo impiegato. I principali algoritmi utilizzati sono quattro:

Senza addentrarci nei dettagli possiamo dire che le principali differenze consistono nel dare priorità in maniera diversa a quattro fattori fondamentali:

I vantaggi di un’infrastruttura dotata del supporto di una soluzione di bilanciamento sono molti. Li riassumiamo qui schematicamente:

In un sistema di delivery finalizzato a massimizzare le performance e la sicurezza, il load balancing rappresenta uno dei moduli di un’infrastruttura più articolata, nella quale si situa al primo livello di interazione con l’utente.

Come si è visto, l’integrazione di un sistema di load balancing rappresenta un importante contributo sotto molti aspetti: nell’ottimizzazione delle risorse, in termini di sicurezza e di incremento delle performance di caricamento delle risorse. Un’infrastruttura disegnata per fornire un servizio web veloce e affidabile non può dunque prescindere dall’implementazione di un load balancer.

iSmartFrame integra nella propria infrastruttura di erogazione load balancer con gestione delle politiche di smistamento personalizzabili. Ogni datacenter ha i propri load balancer a controllo della catena di erogazione dei contenuti, con nodi distribuiti in tutto il mondo. Prima di servire una pagina HTML vengono eseguiti oltre 100 task di ottimizzazione, con enormi benefici per la velocità e, di riflesso, per la user experience e il posizionamento sui motori di ricerca.